본 내용은 fastcampus 딥러닝/인공지능 올인원 패키지 online을 정리한 것이다.

의존성이 있는 함수의 계산:

서로 서로 계산에 관계가 있다.

단점은 : 중복되는 연산이 있을 수 있다.

동적 계획법 : Dynamic Programming -> 알고리즘

첫 계산시 값을 저장하므로 중복 계산이 발생하지 않는다.

나중에 사용할 것을 미리 저장하고 나중에 사용한다.

피보나치 계산 등 동벅 계획법을 사용하였다.

Recursion(재귀)

연쇄 법칙 Chain Rule:

연속된 두 함수의 미분은, 각 함수의 미분을 연쇄적으로 곱한 것과 같다.

심층 신경망의 미분: 연쇄 법칙을 이용하려면 손실 함수의 미분이 필요하다.

저장해 두었다가 중복 연산을 피할 수 있다.

앞쪽으로 미분을 계산하는 것이 역전파 학습 법 : Back-Propagation

블랙박스 모델의 학습:

학습 목표 : 손실 함수를 최소화 하는 매개변수를 찾는다.

수치적 기울기: 각 스칼라 변수를 각각 조금씩 바꾸어 대입해 보면서 수치적 기울기를 구한다.

fully connect layer:

sigmoid 함수의 미분:

역전파 알고리즘: BP

수치미분

python 환경설정

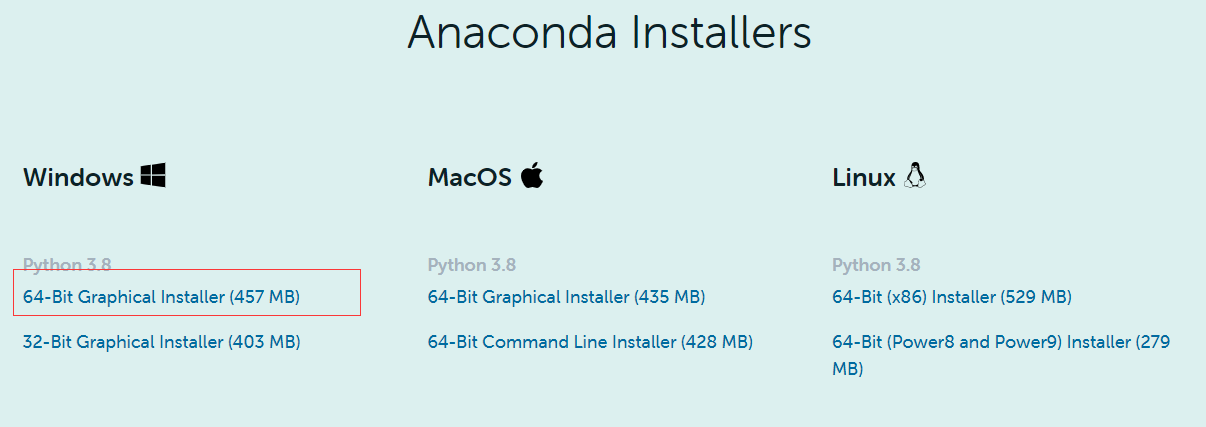

anaconda 로 설치 -window

www.anaconda.com/products/individual#windows

Anaconda | Individual Edition

Anaconda's open-source Individual Edition is the easiest way to perform Python/R data science and machine learning on a single machine.

www.anaconda.com

설치

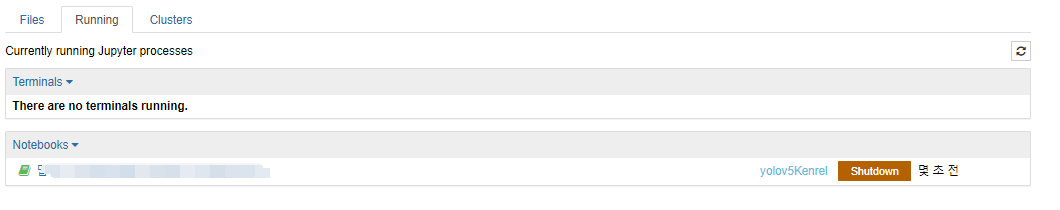

jupyter notebook Launch 한다.

New => Python로 해서 새로운 파일 생성한다.

파일이 녹색으로 되여있으면 실행중 이다.

합성공 연산과 이미지 필터

아날로그 신호처리

LTI 시스템은 선형적이고 시간의 영향을 받지 않는다.

사람은 LTI시스템이 아니다.

Dirac 델타 함수

임펄스 응답 : -> filter

Convolution

함수 두개를 합성해서 곱한다.

두 함수의 곱을 적분하여 계산

겹치는 부분에 적분을 한다.

잡음 제거 필터

2차원 신호

흑백 영상은 각 픽셀이 0~1 사이의 실수로 된 2-D 신호로 표현할 수 있다.

컬러 영상은 RGB 3채널로 구성된 2-D 신호로 표현할 수있다.

합성곱 계산

양상과 겹치는 부분을 곱한다.

잡음 제거 필터 :

가우시안

미분 필터

뉴런: Nureon

input

weight

bias

Convolutional layer

의미: '특징' 이 나타나는 위치를 찾아내는 것이 다.

특정 위치의 값을 크게 해주는 것이다.

pooling layer: 영상의 크기가 줄어들고 , 정보가 종합된다.

average, max

flatten : 아무런 연산도 안일어난다고 생각하면 된다.

fully connected layer: 추출한 특징을 얕은 신경망을 사용하는 것과 동일하다.

Receptive Field: input 영상이 있을 경우 얼마만큼 차지하는 범위

LeNet - 5 : 98년도

VGG-16: 2014년도

Convolutional layer

Feature map

padding

zero-padding

stride 하나씩 거너뛰여서 한다. 출력의 크기가 줄어든다.

pooling

배치 정규화

vanilla gradient descent

stochastic gradient descent SGD:

gradeint 를 한번 업데이트 하기 위해 일부의 데이터만을 사용한다.

mini batch 학습법

학습데이터 전체를 한번 학습하는 것을 epoch

한번 gradient를 구하는 단위를 batch라고 한다.

Internal Covariate shift

Batch Normalization : 정규분포

Training Phase:

학습 단계에서 들어갔을 경우 , 정규화를 한다.

각 배치별로 계산

Batch Normalization -> Relu하면 0아래 다 날라서 그래서 결정 해주는 것이 있다.

Batch Normalization로 인해 , 모든 계층의 Feature 가 동일한 Scale이 되어 학습를 경쟁에 유리하다.

추론 단계 Inference Phase:

training 으로 아니면 test로 하는지

합성공 신경망 역사

GoogLeNet(Inception) -> 복잡하다.

Inception 모듈

다양한 feature를 나누어서 학습한다.

Bolleneck구조 : 연산량을 줄이기 위해 1x1 합성곱 계층. 이러한 구조 줄어든 개수의 영역

연산량을 줄인다.

Receptive field를 유지하면서 파라미터의 수와 연산량을 줄였다.

파라미터 수 줄이는것은 연산량을 줄이는 것과 같다.

추가적으로 분류기 달아서 기울기 소실 문제 해결한다.

Residual Network

Facebook에서 딥러닝 네트워크

152 layer

skip-connectin : Feature 를 추출하기 전후 더한다.

Identity Mapping:

Pre-activation

Densely Connected ConvNets DenseNet

중간중간에 Dense를 하나 추가한다.

ResNet의 아이디어를 계승하여

Dense Block

Growth Rate = 4 => 4만큼의 feature를 만든다.

Bottleneck구조 : 급격하기 증가하는 것을 막기 이해 , 연산량을 줄인다.

'교육동영상 > 01. 딥러닝인공지능' 카테고리의 다른 글

| 11 . 순환 신경망 (0) | 2020.12.07 |

|---|---|

| 10. 합성곱 신경망 구현 (0) | 2020.12.04 |

| 08. 딥러닝 기초 (0) | 2020.12.02 |

| 07. 이미지 분석 pytorch (0) | 2020.12.01 |

| 06. 이미지 분석 tensorflow 2.0 (0) | 2020.11.25 |