728x90

반응형

딥러닝의 기본 개념: 시작과 XOR 문제

input weight 곱

합쳐주고 sum

bias 더해줘서 그 다음으로 전달한다.

이상이 되면 활성화 아니면 비 활성화

신호가 들어와서 어떤 값으로 곱해지고 weight + bias activation function 이 있어서 특정 값 보다 크면 활성화

AND /OR / NAND => Linear 로 구분할 수 있다.

xor

값이 같으면 0 다르면 1로 된다.

perceptron

여러개 쌓이는 것 가능하는데 w,b 학습 할 수 없다.

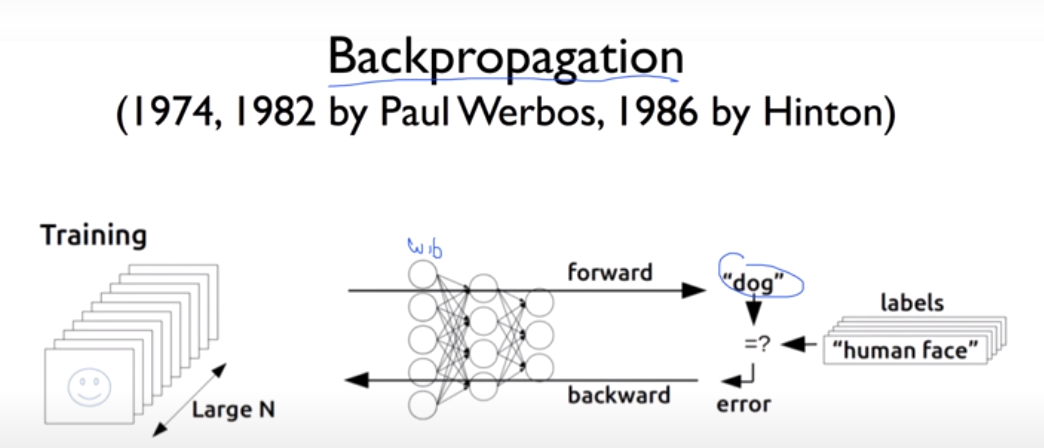

1986 년도에 backpropagation으로 해결 가능하다.

LeNet -5 Lecun

Convolutional Neural Networks

조금씩 잘라서 나중에 합친다.

backpropagation 몇개는 잘 되는데 층이 많을 수록 성능이 떨어진다.

딥러닝의 기본 개념2: Back-propagation 과 2006/2007 ‘딥’의 출현

몇개가 잘 안되는것은 잘 되는데 층이 깊은 것은 잘 안된다.

LeCun 캐나다로

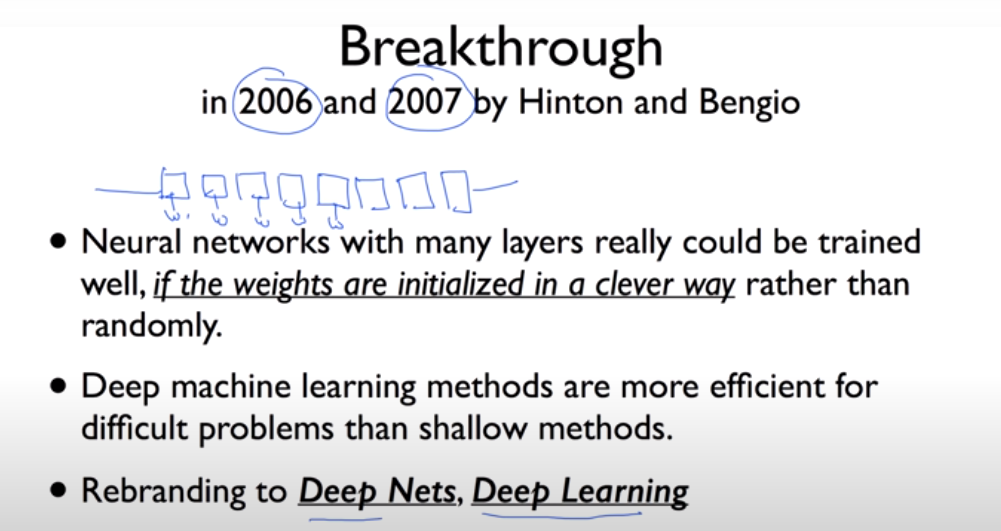

초기값을 잘 못 줬다 . 2006

2007 년에는 초기값을 잘 주면 깊이 가는 것 풀 수 있다.

IMGNET

2012 AlexNet

반응형

'Machine Learning > 머신러닝과 딥러닝 BASIC' 카테고리의 다른 글

| Neural Network 1: XOR 문제와 학습방법, Backpropagation (0) | 2021.07.04 |

|---|---|

| Neural Network 1: XOR 문제와 학습방법, Backpropagation (0) | 2021.07.04 |

| ML의 실용과 몇가지 팁 (0) | 2021.07.03 |

| Softmax Regression (Multinomial Logistic Regression) (0) | 2021.07.03 |

| Logistic (Regression) Classification (0) | 2021.07.03 |