728x90

반응형

Logistic Classification의 가설 함수 정의

가설함수

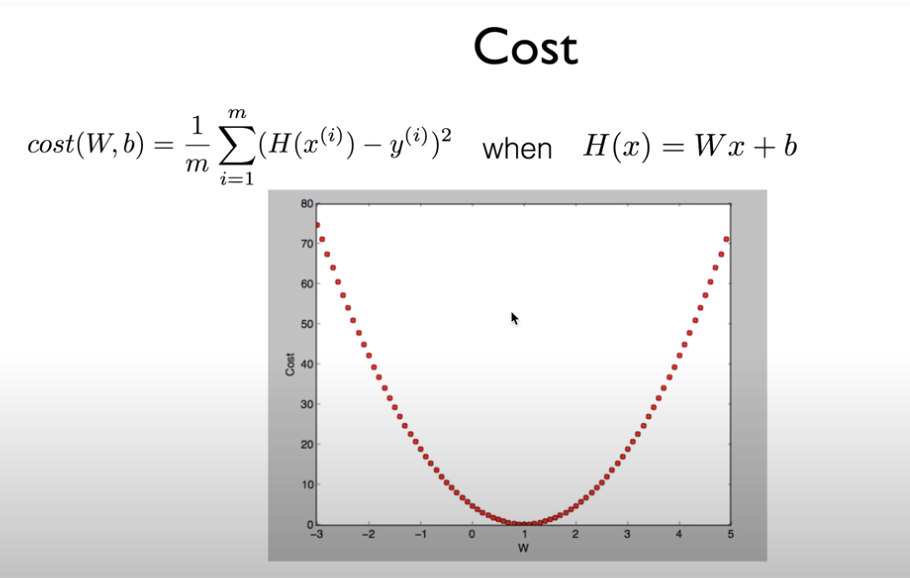

Cost는 실제값과예측 값의 차이

최소화 해야 한다.

경사하강법으로 내려 간다.

기울기는 우리의 cost함수가 미분을 한 값 w, b

Step: 얼마나 움직일가. Learning rate

Classification : binary

Spam or ham

show or hide 좋아요 가지고 학습해서 한다.

Legitimate/fraud : credit card 잊어버릴때

0,1 encoding : 기계적으로 학습하기 위해서

예:

주식 살가 팔가

예: 몇시간 정도 공부 했더니 pass or fail

Linear Regressoin : 단점 : 한 분이 다른 분과 다르게 50시간을 공부할 경우 선이 기울어 질 수 있다.

우리가 classification 0과 1사이 로 나와야 하는데

1보다 휠씬 큰 값이 나 올 수 있다.

W = 0.5, b=0

가설함수는 1보다 크거나 0보다 작은 값이 나올 수 있다.

H(X) =WX +b

G(z) 0~ 1 사이의 값으로 만드는것

Logistic function

sigmoid function

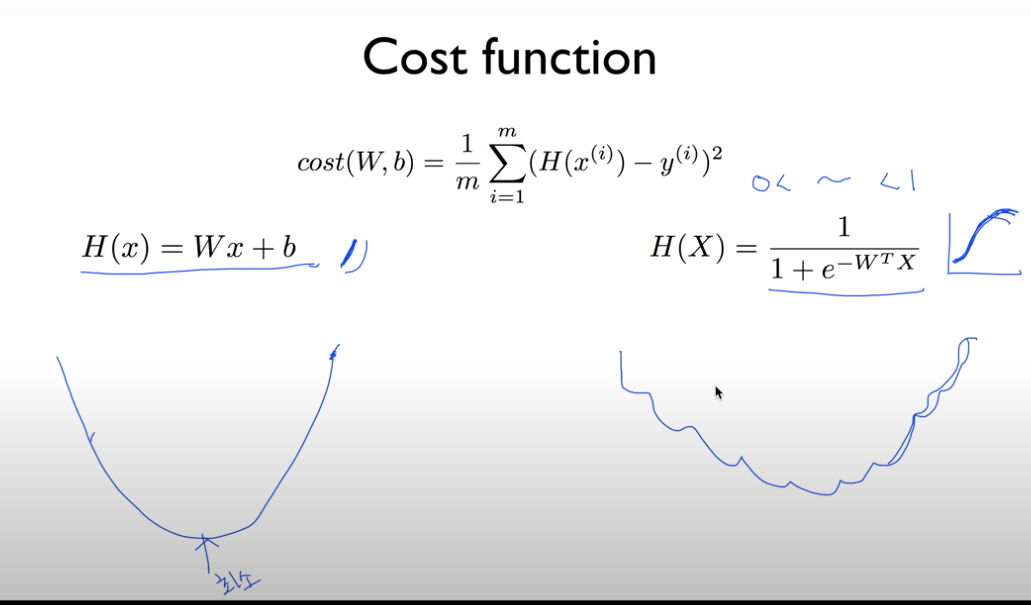

Logistic Regression의 cost 함수 설명

오늘쪽 그림에서 시작점에 따라 최소점이 다를 수 있다.

local minimum

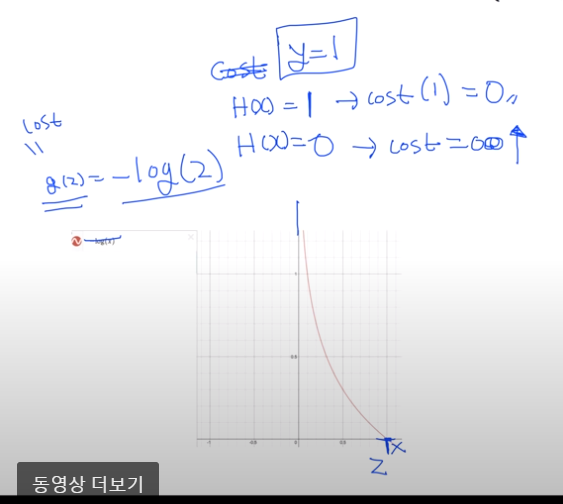

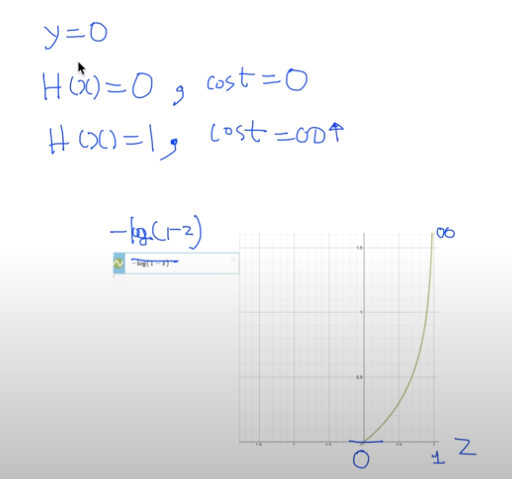

exponential이 있다 . 상반되는 것이 log이다.

cost최소화하기 위해서

예측이 틀리면 0이여서 무한데로 간다.

시스템이 잘못 예측할 경우 크게 한다.

cost주어지면 minimize한다.

기울기를 구하기 위해서 미분을 한다.

반응형

'Machine Learning > 머신러닝과 딥러닝 BASIC' 카테고리의 다른 글

| ML의 실용과 몇가지 팁 (0) | 2021.07.03 |

|---|---|

| Softmax Regression (Multinomial Logistic Regression) (0) | 2021.07.03 |

| 여러개의 입력(feature)의 Linear Regression (0) | 2021.07.01 |

| Linear Regression cost 함수 최소화 (0) | 2021.07.01 |

| Linear Regression 의 개념 (0) | 2021.07.01 |