반응형

학습 rate, Overfitting, 그리고 일반화 (Regularization)

cost function 최소화하는것

gradient descent

learning rate:

large: overshooting step 이 크서 처음에 시작해서 밖으로 튕겨나갈 수도 있다.

발산

small: takes too long, stops at local minimum

cost 함수

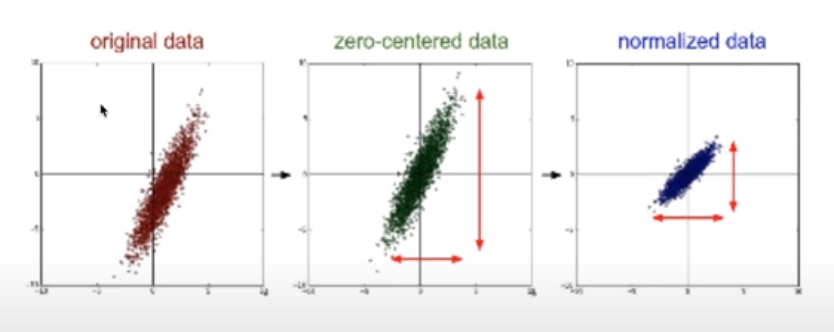

Data(X) preprocessing for gradient descent

다를 경우 외국된 현상이 생긴다.

zero-centred data: 중심이 0으로

normalized data:

데이터중에 차이가 큰것 있는지 확인

overfitting

머신러닝은 학습을 통해서 만들기 떄문에 학습 데이터에 너무 많은 것

실제로 테스트 데이터는 안 맞을 수 있다.

solution:

데이터 많이 수집하기

reduce the number of features

regularization

weight 큰 값을 가질 경우 구불어진다.

Training/Testing 데이타 셋

데이터 가지고 학습을 시켰다.

training

testing

regularization에 람다를 학습할떄

mnist data set

우편번호

반응형

'Machine Learning > 머신러닝과 딥러닝 BASIC' 카테고리의 다른 글

| Neural Network 1: XOR 문제와 학습방법, Backpropagation (0) | 2021.07.04 |

|---|---|

| 딥러닝의 기본 개념과, 문제, 그리고 해결 (0) | 2021.07.04 |

| Softmax Regression (Multinomial Logistic Regression) (0) | 2021.07.03 |

| Logistic (Regression) Classification (0) | 2021.07.03 |

| 여러개의 입력(feature)의 Linear Regression (0) | 2021.07.01 |